Transphobe évidemment, je crois qu'il faut en faire un grand principe, mais aussi un vrai sujet.

L'un des héros de la chose (1), trans lui-même, "iel" explique tout ça en y réfléchissant et arrive à communiquer ce qui n'est ni anodin ni non existant, bien au contraire, il va falloir se confronter.

On commencera par ce qui apparait comme essentiellement contradictoire au sens plein: on accumule des affirmations dans les deux directions, les associant d'autant plus facilement qu'elles se nient l'une l'autre, non pas comme phases d'un devenir, mais comme "étants" dans le langage.

D'abord le sexe non binaire pour Butler, et trans pour le trans, qui a transité en féminin et masculin. Refuser la binarité en assumant par choix, ou par force l'autre face de la binarité c'est se contredire: la négation d'une binarité c'est sa disparition, pas son exacerbation ou sa manipulation forcenée publique et spectaculaire. Nier la féminité en exigeant d'accomplir sa masculinité n'est pas remettre en cause la masculinité, c'est la fétichiser. Je n'arrive pas à sortir de là et on a là une pathologie, un déni de l'absurdité de son projet et de son état qui fait trembler. Volontaire ? Signifiant ? Et bien cette folie là reste une folie, et on a le droit de ne pas s'en saouler.

Le patriarcat décrié est ce qui assure aux sexes leurs lisibilités symboliques, un bon père de famille ou son pendant symétrique, la bonne mère de famille ( le slogan patriarcal au sens vrai de Valérie Pécresse) en assumant l'égalité des positions de part l'évidence de leurs nécessités respectives, les vagabondages sociaux, sexuels ou salaces des originaux qui s'excitent n'étant que jeux, et les jeux sexuels ne sont que des déguisements, à distinguer des vrais vêtements.

Ensuite le non racisable, l'autre face du modèle, qui célèbre la mort de la nation coloniale ou colonisatrice, celle que vivent les voyageurs qui viennent habiter les métropoles occidentales, faute d'assumer une indépendance misérable impossible. Gardiens de musée comme par hasard ils souffrent donc de leur racisation, s'adaptent ou non (Franz Fanon par exemple, ne semble pas s'être adapté) et se trouvent donc comme les immigrés légaux ou les migrants illégaux, confrontés au Rap , qui n'en finit plus de célébrer les conséquences mal maitrisées d'une abolition de l'esclavage dont on se demande s'il faut s'en venter de peur de vexer, l'affranchi se considérant toujours mal indemnisé, son reproche s'adressant exclusivement à son "histoire" de racisé, ses ancêtres les prédateurs qui ont vendu leurs parents ne comptant pour rien, en parler vexe aussi.

Là on veut abolir les nations, LA nation, son principe même, dans un élan simultané pour mélanger la deuxième négation du binaire le noir/blanc, celui-ci se fait bien sur au bénéfice du noir et de sa nation à lui, le reste du monde se liguant donc pour abolir la nation du blanc, celui-ci ayant le mauvais gout de continuer à administrer la terre sur laquelle on s'est installé et qu'on voudrait piller à loisir.

Dans les deux cas s'affirme une binarité exclusive que l'on restaure dans un autre sens, la première mouture de la modernité sexiste et raciste s'étant amendée, mais insuffisamment, comme égalitaire et se permettant (hypocritement bien sur ) de prononcer des égalités symboliques, les pires, celles que l'on doit maintenant abolir.

La deuxième phase de la conquête (finalement la première n'était qu'un hors d'oeuvre) est donc bien la destruction du monde, du moins de son aspect familial ET national, et voyons voir comment elle s'affiche et se pense.

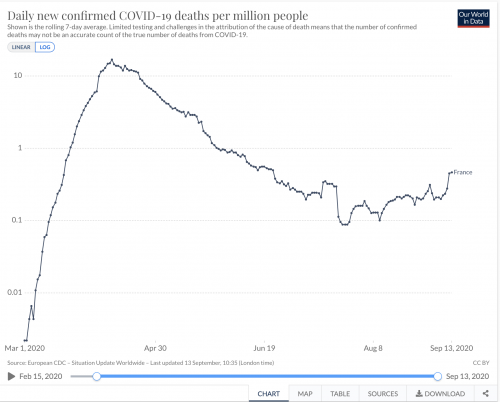

D'abord une splendide considération étymologique sur le mot "munne" (impôt, don, obligation, devoir) dont vient le commun et aussi bien l'immune(exonéré) et le démuni (exclus). On en vient à l'état d'exception, qui frappe le dominé et le dominant qui frappe aussi. C'est le bio-politique, le social qui s'adresse aux corps racisés ou contaminés et le passe sanitaire vaut papiers pour les sans papiers, les lépreux étant noirs ET contagieux. Le parallèle covid/réfugiés avec comme source commune le changement climatique vaut vision du monde globalisé cohérente et convaincante...

On en vient alors et aussi à la psychanalyse, dont l'obsession sexuelle est gênante (c'est binaire œdipe) et on lui reproche finalement, après l'avoir admirée et utilisée à tort comme expression du sexuel que le patriarcat voulait cacher, de ne pas "soigner" le mal qu'elle nie. Beau et émouvant reproche.

On mentionnera au passage "les" psychanalyses, la théorie d'un escroc juif réactionnaire et incestueux célébrant le patriarcat barbare injustement aboli par des fils devenus névrosés, se reprochant de ne pas tringler avec assez de vigueur les sous hommes sans pénis qu'on appelle "femmes" (la non binarité semble issue d'un dégout finalement légitime) à moins que ce ne soit le contraire, le freudo marxisme célébrant par l'orgie la ruine du capitalisme acharné à refouler au nom du profit les légitimes libidinalités primaires, qui plus est inconscientes, et donc naturelles qu'il faut encourager et célébrer, c'est Nietzsche qui nous le recommande. Voir plus bas.

La contradiction

Revenons à la contradiction première (2).

"Grâce à des rencontres, des lectures, j’ai commencé à déconstruire la notion de binarité, à comprendre que les catégories de genre étaient des catégories sociales, des fictions politiques. J’ai compris que je me sentirais davantage à ma place dans la catégorie homme." On pense se sentir mieux dans une catégorie fictionnelle, quitte à violer tous les usages et toutes les conventions dont on proclame par ailleurs soi la non existence soit le caractère provisoire fragile et dérisoire...

Comment se satisfaire d'un tel discours ?

Surtout que pardessus le marché, on y fait l'éloge d'une "gender fluidity" qui pourrait s'admettre et qui d'ailleurs avec les progrès de la tolérance envers les êtres, leurs cultures spéciales, leurs excentricités variées permettrait de vivre avec, précisément le fait d'assumer à la fois les différents genres déclinés en sexualités différenciées et expressions mixtes. Non. On veut assumer publiquement le corps du sexe qu'on n'a pas. Là encore contradiction dans les termes, les attitudes, les pensées, les dires. On pense à la revendication masculiniste. Dotés de culottes collantes qu'on ne qualifiait pas de "moule burnes" à l'époque, tout le XVIème et le XVIIème siècle se voulurent exposer au public testicules volumineuses et mollets rebondis: l'entrejambe puis la jambe célébrèrent à la vue de tous la puissance charnelle de la virilité agressive nobiliaire : à l'époque des duels et de l'affirmation permanente, colorée et prétentieuse, de la virilité on revendiquait en plus du patriarcat la violence essentielle du mâle essentiel. Et bien cela est passé de mode, et quoiqu'on en dise, le moule burne actuel reste une mode "homosexuelle", la célébration du corps essentialisé de l'homme n'étant plus que connoté et le gros musclé culturisé a forcément (du fait des hormones qu'il s'enfile) un petit kiki.

Continuons avec la "gender fluidité". Sans doute que cette revendication contradictoire là est en fait bienveillante, le trans authentique se voulant "en avance" et se gardant une armée de réserve avec les trans "honteux" qui se conservent lâchement leurs gonades et qu'on méprise un peu en les mettant en avant pour faire écran. Un autre aspect est donc aussi que le "trans" qui se décrit lui-même ici (2) ne se déclara pas homme "cis" mais homme "trans". C'est peut-être la voie pour comprendre et accepter une logique qui se veut donc sexuelle, disons néo-sexuelle, un personnage nouveau (le fameux "monstre") innovant dans le sexuel et le revendiquant.

On se souvient de cette utilisation du mot "le sexe" pour désigner le féminin, la femme "publique" représentant personnellement cette activité abolie par les relations exclusivement masculines entre les seuls "sujets", à la fois hors du sexe qu'on ne mentionne jamais et uniquement sexués par ailleurs du fait de la discrimination... Là aussi il y avait contradiction, comme à quoi toute tentative d'affranchissement de la chose s'expose logiquement... La mise en avant du sexe pour nier ou affirmer la polarité s'expose à la contradiction, comme si cette dualité avait à voir, déconstruction oblige, avec le vrai et le faux... Mais nous voilà dans un autre binaire à abattre et la "déconstruction" du monde a bien toutes ces polarités en ligne de mire, comme de juste. Tremble, informatique, le calcul quantique va te niquer à la fin.

On se souvient aussi du mot "genre" abondamment présent dans toutes ces arguties, et qualifié par Mona Ozouf de "cache-sexe". Le pot aux roses est dévoilé et la femme est nue: on veut la mort du sexe. "Le sexe est mort, nous l'avons tué".

Considérer devoir se passer de concepts aussi utiles est donc un jeu comme tous les jeux impossibles des enfants. Faut-il redevenir gamins pour jouer à la philosophie (post) moderne du nouveau monde, les vrais adultes ayant "progressé" (les progressistes)?

Et puis il y a les colonisés, par exemple les talibans en voie de libération, à défaut de développemnt qui pratiquent une homosexualité gentille à l'antique, les hommes se tenant par le petit doigt dans les bazaars, et faisant danser des gamins déguisés en fille, le plus violent des guerriers ayant le droit de le sodomiser à la fin... Privés de femmes mais pas de trous, les afghans queers sans doute vérolés par la barbarie d'Alexandre, puis par les américains gays vont pouvoir maintenant, évacuation oblige, donner toute leur mesure, sous la burka, c'est simple, on peut trouver n'importe quoi...

La psychanalyse

Paul Preciado est un trans courageux qui va déclarer aux psychanalystes la nécessaire réforme de leur art ! "Le monstre qui parle" y va carrément (3) et réclame la révolution du genre et encore mieux, il faut savoir à qui on a affaire: "décoloniser l'inconscient". Magnifique projet qui de refaire à ce qui n'existe pas ce qu'on dénie avoir fait des mères patries...

L'homme a donc pris des hormones, pour "décoloniser son corps" et pouvoir justifier du respect du aux hommes... Il du bien sur regarder différemment (ne plus baisser les yeux et sourire bêtement, par exemple).

En parlant de décoloniser une belle saillie: le corps "trans" est à l'hétérosexualité ce que Lesbos est à l'Europe : une frontière !!! (Elle est pas mal celle là).

Faire la transition (physique) c'est enfin comprendre que les codes (culturels ) du masculin et du féminin sont anecdotiques par rapport à l'infinité des modalités de l'existence... Le couteau est indispensable: on ne comprends pas sinon et foin de nichons et de bites en trop ! Il faut couper ! Il faut couper !

Une image qui doit passer par bien des têtes de psychiatres: l'insondable futilité de ces femmes qui croient en l'efficacité du pénis et du sperme qui en sort et dont elles s'enduisent pour "changer" enfin !

Le trans "n'imiterait pas": il serait la vraie "nature" le vrai en soi, interdit aux répétiteurs sexués du milliard d'années de conformation génétique: l'artificiel n'imite pas, il est le "réel" car c'est imiter qui est vrai, le réel ne peut se passer d'intention...

Pour tout dire, et on en arrive à la thèse: les codes féminins et masculins n'ont plus d'intérêt et on peut s'en libérer complètement pour avoir une vie meilleure. Il y a là demande de reconnaissance de droit pleins à ceux qui étaient considérés comme subalternes... Cela même si on ne voit absolument pas ce qui empêche le trans de voter, l'isoloir ne mesurant pas son sexe... On a là d'ailleurs une autre contradiciton: la revendication de droits citoyens sexuels dans un décor démocratique qui a justement abandonné la différenciation sexuelle, (dés avant la guerre en Turquie). A merde j'ai oublié la loi sur la parité: elle doit s'étendre donc !

Au passage, on évoque 3 points: le paradigme historique sexuel changeant (le passage du mono-sexuel du moyen-âge à la différenciation scientifique des sexes), la non réalité du sexe due à l'intersexualisation (exemple le docteur Money), l'inéluctable changement sexuel social qui s'annonce inéluctablement. Ainsi donc, le fait est dans le futur: l'épistémologie de la différence sexuelle est en mutation.

Lacan (c'est un peu mon diagnostic) identifie transexualité et confusion sémiotique entre organe et signifiant. La réponse est cinglante: c'est bien ceux qui identifient le sexe à la naissance qui confondent...

Le projet

Le projet "trans" intersectionnel de destruction du cadre familial et national étant acté, il convient de le caractériser en tant que tel, c'est à dire comme un projet de vie, de civilisation à venir, qui serait débarrassé, et cela est l'expression même de ses thuriféraires, "des différences sources de la domination".

La binarité est donc bien sur celle du pouvoir, la racisation et la sexualisation introduisant une différence qui ne peut être que celle qui apparait entre le dessus et le dessous, le dessous souhaitant passer dessus et le dessus criminel devant être soit détruit et puni, soit aboli et exterminé.

L'abolition de la domination peut se décrire de pluieurs manières, depuis la mélancolie originelle du trans triste avant la transition et qui forcément se mettra aussi à regretter après ce qui était son avant plein d'espoir (cela est sur), mélancolie essentielle et significative qui se traduit donc par une tristesse utopique assumée. Habitué 1 milliard d'années à subir la loi du sexe, on ne pense tout de même pas passer immédiatement à la suite sous le prétexte qu'on a eu le courage de se faire pousser ou de s'être coupé la bite. La forme littéraire, donc.

On a mieux: on a le politique terrorisant décalqué du bolchevisme, avec la nécessaire violence destinée à solder les comptes de l'ultime résistance et puis aussi l'appui sur le psychanalysant, le patriarcat détesté se devant de céder la place à un matriarcat bien plus tolérant des frolements lesbiens, destinés à devenir la règle de l'échange sexuel, quelque soit la direction d'où l'on vient. Les sodomies brutales sont donc réservées au "pédé" dont le nom glorieux devient donc seul, évocation de l'ancienne virilité maintenant exclusivement destinée à justifier dans le réel l'universel vocable d'"enculé" devenu presque amical. Plus besoin donc de pénétration classique à l'âge de la pipette, on se fait inséminer comme on se fait vacciner: en deux petites doses.

Le projet est cohérent et le métissage indispensable concomitant est obtenu par le moyen même, c'est l'état en charge de l'éducation des peuples qui décide au mieux des intérêts bien compris de tous et chacun. La paix et la santé sont à ce prix.

Le mot "progressisme" vient à l'esprit. Bien sur.

La réponse

Il faut que cet idéal soit combattu. Par un esprit qui soit d'abord celui du bon sens, au nom de l'évidente absurdité de cette tentative de suicide matériel et moral. Méprisé universellement et combattu par tout le reste du monde, slave, chinois, indien et africain cet idéal est évidemment destiné à disparaitre faute de combattants et d'envie de se battre. Suicide ? Transition vers les étoiles et sortie du monde, une forme particulièrement blafarde de nihilisme esthétique destiné à bercer les cris des suppliciés lors de la prise de Bysance: la fin d'un monde devenu inutile sauf à servir d'exutoire à une soldatesque qui peut enfin jouir sans entraves pendant au moins un temps, après patienté tout un long siège.

Après cela, le patriarcat et ses conséquences pourra enfin revenir, sous ses formes non occidentales simplement un peu plus rudes, mais après tout, "ils" y sont déjà habitués...

Il y a d'autres raisons que la simple géo politique. On a parlé de l'absurdité logique de la négation du binaire, stupide et infâme déni du monde, il faut parler de l'humanité tout simplement en ce qu'elle est d'origine plus qu'individuelle et c'est toute la réflexion qu'il faut mener.

Alors que toute la civilisation occidentale oeuvre depuis le début de sa philosophie pour définir un être conscient, en gros le fameux "sujet" dont a raison de vouloir se débarrasser, car depuis ses début comme père de famille esclavagiste il est une bite à couper, alors donc, il n'a pas cessé à travers cette même philosophie de se forcer lui même à s'insérer dans des dispositifs concients de supervision collective. Seule garant de l'indidivu, le collectif est ce qui lui permet de vivre tranquille et se doit d'être organisé.

On distinguera donc les dispositifs sociaux de l'humain occidental, ceux ci ayant une fonction traditionnelle mais aussi une fonction d'expression de l'individu. Au point que ce collectif là, désormais conscient ait pu croire se choisir lui même hors de toute contrainte, l'abolition de la mort étant désormais au programme que l'on soit Macron cherchant à se faire réélire malgré sont évidente inutilité. Où en étais-je ? Ah oui: le social occidental est une expression de l'individu, c'est ce qui le caractérise.

En cela, il doit alors philosophiquement surmonter un paradoxe fondamental qui est de concevoir malgré tout un social qui ne soit pas son individu, précisément, car sinon, cela signifierait que l'un des deux, l'individu ou le social ne serait rien, ce qui serait dommage. Cela entraine une conception à travailler le "binaire", précisément ce que la pointe avancée de la civilisation se propose de détruire dans son principe et qui donc a tort.

Plongé dans le personnel de l'état de soi, le sexe, dans le collectif de l'état des autres peuples, la nation, pour ne pas parler du collectif avec l'autre absolu, Dieu (on verra ça un autre jour), l'essence de l'homme ne peut se concevoir elle même que binaire et cette affirmation là, désolé, nous ne souhaitons pas la déconstruire, mais la fonder. Merci de votre collaboration.

Cette conception là de l'individu a sa racine dans la conception philosophique même de ce qu'est l'être individué, au delà de toute caractéristique, et donc libre essentiellement du reste de son être qui peut alors se manifester pleinement. L'individuation est essentielle, c'est l'hacceité, indépendante de toute matière et garante de l'unité exceptionnelle de l'individu un.

Les collectifs sexuels et nationaux ont une réalité et leurs abolitions ne sont nullement nécessaires à l'affirmation de la liberté qui est DEJA pleine et entière malgré toutes les carapaces. Sexe ou Nation sont des masses porteuses d'être au delà de l'individu réel et font de l'être humain une chose complète, libre ET déterminée, présente dans le réel donc. Mais pour cela il faut distinguer la chose de ses attributs, essentiellement !

La théorie

L'humain, le sujet est donc à la fois confronté à son état extérieur de genre, de souffrance et de condition, et aussi à ce qu'en dit la collectivité auprès de qui il dit aussi ce qu'il est. Le tryptique nature, sujet, collectivité est le statut global est essentiel de l'homme, minéralement enchassé dans le réel. Cela n'est pas virtualisable autrement que de manière fictionnelle.

Au fait, il y a deux sortes de fictions: les explicites et les implicites. Les fictions sociales par définition, ne peuvent être explicites car cela établirait leur mensonge ce qui est inacceptable. Une fiction peut exister mais se trouve soit implicite et indétectée, soit contradictoirement et cyniquement instaurée. La virtualisation évoquée, essence du progressisme et de ses songes creux se trouve donc essentiellement invalidée.

Minéralement établie, on peut alors en toute conscience faire face au projet évoqué plus haut, et dont il faut caractériser l'ampleur et je ne plaisante pas.

Il s'agit de supprimer la différence sexuelle, dans l'inéluctable d'une société totalement fluide dans le genre et dont l'enfantement serait assuré par des technologies utilisant des animaux, des embryons élevés pour cela, ou des individus volontaires assumant leur role. Le reste, disposant des hormones de caractérisation permettant l'accès à tous les désirs et tous les comportements pourrait se satisfaire de toutes les chirurgies et de toutes les prothèses associées pour satisfaire tous les désirs ou toutes les obligations. Car il faut réaliser que l'obligation de l'"état homosexuel" (ou transgenre) vécu et décrit comme involontaire et constitutif de son sujet par les sujets eux même se trouverait en concurrence avec l'"état de curiosité" de ceux qui librement, par distraction ou volonté pure souhaiteraient disposer des mêmes technologies, avec les mêmes droits. On se trouve alors avec une indicernabilité fondamentale, preuve d'ailleurs de la futilité fondamentale de la chose, entre obligés et volontaires de la fluidité de genre devenue essentielle et générale.

Plongé dans le fondamental du sexué quoiqu'il arrive, une telle société au demeurant possible se trouve toutefois soumise à l'assentiment de ses membres confrontés, c'est l'aporie de la planète, aux autres cultures, sociétés ou nations qui pourraient ne pas en partager le aspects. C'est un problème, la question des oppositions anthropologiques essentielles entre les peuples resurgissant après la période bénie qui permit l'abandon du chèche et de la natte et l'adoption du pantalon sur toute la planète. Cela en plus dans des sociétés déjà au moins partiellement multi culturelles, et la déracisation intersectionnalisée avec la désexuation pourrait trouver ses limites dans les ghettos ethniques et religieux sur notre propre sol.

Pour l'instant cette aporie là sert surtout à empêcher toute assimiliation des peuples africains immigrés ou migrants, tout simplement horrifiés par l'évolution en cours du monde occidental, qui se met à abandonner tous ses principes. Les nouveaux arrivants sont en train de se décider à coloniser, tout simplement, notre barbarie devenant patente. On ne se mélange pas quand on se voit obligé de se mettre un os dans le nez pour cela. On a déjà les voiles et la chicha, à quand les clubs de polo ?

L'autre aspect est bien sur l'irréductible affirmation de Don Juan au sujet de deux et deux qui font quatre et de quatre et quatre qui font huit. Il y aura toujours des dissidents à ne pas être aveugle et à vouloir ne se fier qu'à leur avis propre, matiné de culture mathématique. Le sexe est irréfragable, et rien ne m'en fera démordre, un trav est un trav, même goinfré d'hormones, et la bite arrachée. C'est sa croix, c'est ma certitude.

Un dernier point est la lucidité quant à l'aspect ludique de la chose, quoiqu'il en soit ne pourra pas être aboli, sauf si bien sur cela était décrété, la fiction obligatoire étant une modalité sociale possible, tout comme les violences qui pourraient se manifester à son encontre, d'ailleurs. En tout cas, cette ludicité est déjà présente, consciente ou non et les épidémies de fausses fausses identités chez certains adolescents branchés en quête de nouvelles formes de scarifications plus branchées en ressortent évidemment, le sérieux étant de mise quand on en parle, le rire étouffé sinon. La vraie ludicité cynique, on se souviendra que le fou d'elsa a fini sa vie déguisé entouré de mignons, n'ayant pas de borne, et l'apparente pudicité puritaine de notre époque, acharnée à dénoncer la pédophilie et ses variétés n'en a pas moins succédé il n'y a pas longtemps aux plus extrêmes licences je ne vous raconte pas... Le jeu, vous dis-je, le jeu. En tout cas, il ruine le ridicule droit à l'égalité de la nouvelle race sexuelle, phénomène épidémique construit sur des hasards biologiques et humains tolérés depuis toujours et qui ne furent théorisés officiellement que récemment par la puissance américaine dans des contorions médiatiques dont il ne faut pas être dupe, la rivalité new york / san francisco y étant pour beaucoup.

Les mariées moustachues de notre époque restent essentiellement lamentables, ridicules et minables, leurs réductions d'impôts en rapport pouvant bien les satisfaire, mais pas moi. La ludicité à venir (je suis content du mot) se devant de faire grâce de tout cela, le mariage coluche/leluron m'ayant vacciné.

(1) Paul Preciado: l'interview https://manifesto-21.com/paul-b-preciado-interview/

(2) Un trans F2M https://www.lemonde.fr/festival/article/2018/09/30/ocean-etre-transfuge-de-genre-n-est-ni-grave-ni-une-folie_5362304_4415198.html

(3) https://www.en-attendant-nadeau.fr/2020/07/15/lettre-preciado/

(4) Le livre de Preciado : Je suis un monstre qui vous parle